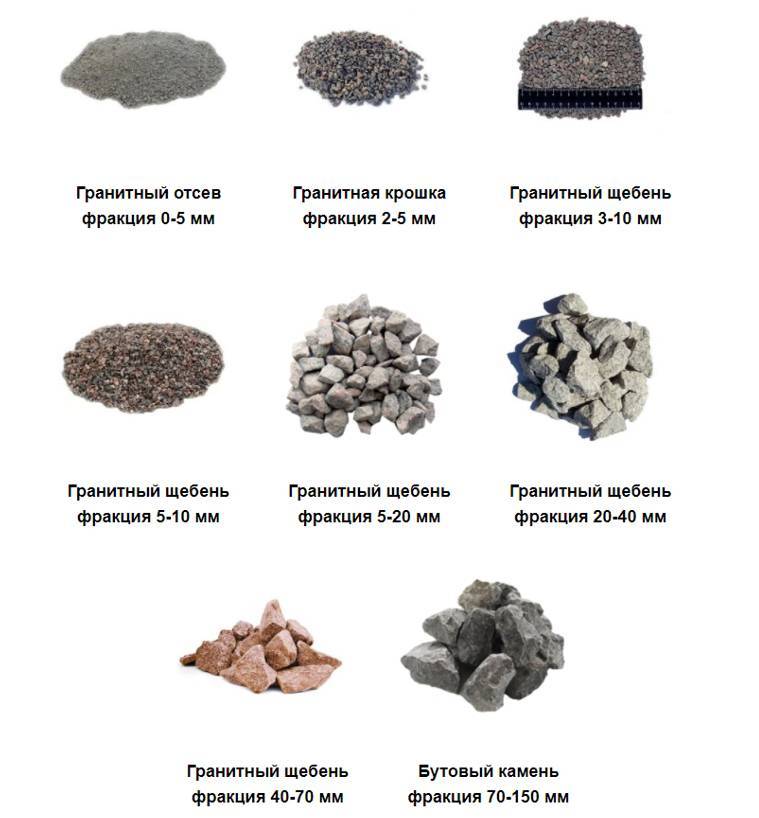

» Фракции отсева

автор: 2018-02-12В процессе переработки горной породы или искусственного камня получают побочный продукт, который широко используется в строительстве и других хозяйственных сферах. Наряду с лещадностью, насыпной плотностью и другими характеристиками, большое значение имеют фракции отсева, поскольку конкретный показатель модуля крупности определяет сферу применения этого материала.

Модуль крупности – это предельно допустимый размер отдельного зерна. В зависимости от размера отверстий сита получают отсев фракции 0 10 мм. При измельчении используется до 20% сырья, в качестве которого может использоваться гранит, гравий, известняк, строительные отходы.

Технология производства продукции выглядит следующим образом. Исходное сырье измельчают с помощью специального оборудования, после чего дробленую массу отправляют на просеивание. Полученный материал с крупностью зерна до 5,0 мм относится к отходам. Перед реализацией продукт проходит лабораторные исследования, где определяют его характеристики и соответствие гранул типоразмеру.

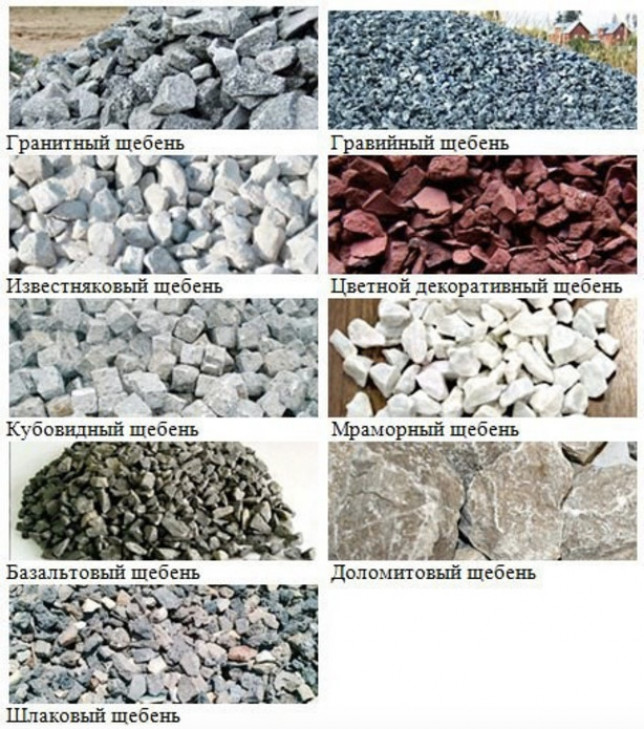

Рассмотрим, какие параметры зерна имеют различные по исходному сырью продукты, в каких сферах они применяются:

- Гранитный. В результате дробления природной твердой породы получают гранитный отсев фракции 0 5 мм. В этом продукте практически отсутствуют примеси, он плотно укладывается и обладает высокой прочностью. Мелкая гранитная смесь широко используется в строительстве, при проведении дорожных работ и оформлении придомовых территорий. В основном, отсев фракции 0 5 мм добавляют при производстве бетонных изделий, плитки, бордюров. Измельченный гранит розового цвета пользуется популярностью при создании объектов ландшафтного дизайна.

- Гравийный. Внешне напоминает переработанный гранит, но имеет другие свойства. В результате переработки получают мелкий отсев фракции с частицами в пределах 0,16 – 2,5. Он отличается рыхлостью, содержит минеральные примеси. Гравийная смесь востребована при ремонте дорог, производстве пыли, создании подсыпки.

- Известняковый.

После пропускания сквозь сита измельченной известняковой породы выходит масса с модулем крупности гранул от 2 до 5. В отличие от других разновидностей, известняковые гранулы растворяются в воде, их добавляют в цемент при приготовлении строительных растворов.

После пропускания сквозь сита измельченной известняковой породы выходит масса с модулем крупности гранул от 2 до 5. В отличие от других разновидностей, известняковые гранулы растворяются в воде, их добавляют в цемент при приготовлении строительных растворов.

Кроме перечисленных видов, востребована крошка вторичного щебня, который получают в результате переработки бетона, полученного в процессе демонтажа различных конструкций. Массу с зерном от 0,1 до 10 добавляют в цементные смеси, подсыпают при укладке тротуарной плитки.

Применение отходов позволяет сократить затраты на строительство и другие работы, рационально утилизировать отходы. Приобрести любой вид продукции по доступной цене и с доставкой по Краснодару можно у компании Инерт Групп, которая занимается производством таких материалов. В ассортименте – известняковый, гранитный, гравийный, бетонный, мытый материал.

Отсев гранитный фракция 0-5 мм цена за куб

Компания «ТСГ» является надежным поставщиком сыпучих строительных материалов, в том числе и гранитного отсева. Заказывая материал у нас вы получаете точную доставку материала на ваш объект. Купить отсев гранитный можно в любое рабочее время по телефону, либо воспользовавшись функцией «заказать онлайн».

Заказывая материал у нас вы получаете точную доставку материала на ваш объект. Купить отсев гранитный можно в любое рабочее время по телефону, либо воспользовавшись функцией «заказать онлайн».

Для получения консультации при выборе материала, обращайтесь к нашему онлайн-консультанту или звоните по многоканальному номеру телефона.

Цены, указанные на сайте, рассчитаны на близкое расстояние места погрузки с местом разгрузки. Более точную информацию вы получите у менеджеров, позвонив по телефону или используя функцию «онлайн консультант».

Характеристики

| Прочность | 1000-1400 |

| Морозостойкость | 300 |

| Насыпная плотность | 1.46 т/м3 |

| Пылесодержание | не более 25% |

| Радиоактивность | 1 класс |

По классу прочности отсев соответствует марке М 1200, что позволяет его использовать не только для посыпания пешеходных дорожек, но и для обустройства дорожного полотна для трасс с большой загруженностью, для производства тротуарной плитки и прочных железобетонных конструкций.

Поскольку отсев — это экологически чистый материал, не содержащий примесей вредных химических веществ, а его радиоактивность находится в пределах позволенных норм, которые определены ГОСТом и ТУ, его широко применяют коммунальные службы для обеспечения безопасности движения на скользких трассах и пешеходных дорогах в зимний период времени. Отсев щебня не содержит никаких химических реагентов приводящих к порче обуви, одежды или колесных покрышек, именно поэтому его антигололедные качества высоко оценены.

Применение

- Производство бордюров, железобетонных конструкций — стоков для дождевых вод или тротуарной плитки, для производства декоративных конструкций на основе бетона, для усиления стеновых конструкций; он придает бетону не только прочность, но и пластичность;

- Отсев может быть двух цветов: серый и красный с оттенком розового, это позволяет использовать его для декоративных целей, например добавляя его к бетону, можно получить отличное мозаичное напольное покрытие, или облагораживать приусадебные участки, создавая различные элементы для ландшафтного дизайна: русла ручьев, пешеходные дорожки, разбивка сада на зоны, нашел он также широкое применение для подготовки спортивных площадок, альпийских горок;

- Дорожное строительство: укладка бетонного или асфальтобетонного покрытия, гранитная крошка не только придаст прочность, но и улучшит коэффициент скольжения дорожного полотна.

Цвет гранитного отсева влияет на цену, поэтому уточняйте для каких целей вы его приобретаете.

Отсев из гранита содержит малое количество пылевых и глинистых частиц — не более 0,4%, содержание зерен неправильной формы может составлять всего лишь 14,5%, а по классу морозоустойчивости она такая же, как и гранит — F300. Таким образом, используя его при строительстве, вы пользуетесь всеми преимуществами гранита.

Обращаясь в компанию «ТСГ», вы получаете высокое качество сервиса, доставка будет произведена по указанному вами адресу в Москве или по области. Стоимость зависит от объема партии поставки, при больших объемах вы получаете существенные скидки.

Понимание отсева с помощью упрощенной математики | Читта Ранджан

Здесь мы поймем математику, которая управляет выпадением. Как это приводит к

регуляризации ? Почему Коэффициент отсева 0,5 приводит к наибольшей регуляризации? Что такое Gaussian-Dropout ? Опубликовано в·

Чтение: 7 мин. 0011

0011Несмотря на сообщаемые новаторские результаты, мало что известно о Dropout с теоретической точки зрения. Точно так же неясно, насколько важна частота отсева, равная 0,5, и как ее следует изменять в зависимости от слоев. Кроме того, можем ли мы обобщить Dropout на другие подходы? Ниже приведены некоторые пояснения.

Архитектуры глубокого обучения становятся все глубже и шире. С этими большими сетями мы можем добиться хорошей точности. Однако это было не так десять лет назад. На самом деле глубокое обучение было печально известным из-за проблемы переобучения.

Рис. 1. Плотная нейронная сеть.Затем, примерно в 2012 году, появилась идея Dropout. Эта концепция произвела революцию в области глубокого обучения. Большая часть успеха, которого мы добились с глубоким обучением, связана с отсевом.

Краткий обзор: что такое Dropout?

- Dropout изменил концепцию изучения всех весов вместе на изучение части весов в сети на каждой итерации обучения.

2. Иллюстрация обучения части сети на каждой итерации.

2. Иллюстрация обучения части сети на каждой итерации.- Эта проблема решила проблему переобучения в больших сетях. И внезапно стали возможными более крупные и точные архитектуры глубокого обучения.

В этом посте наша цель — понять математику, стоящую за Dropout. Однако, прежде чем мы перейдем к математике, давайте сделаем шаг назад и поймем, что изменилось с Dropout. Это будет мотивацией прикоснуться к математике.

До Dropout основной областью исследований была регуляризация . Внедрение методов регуляризации в нейронных сетях, таких как штрафы за вес L1 и L2, началось с начала 2000-х годов [1]. Однако эти регуляризации не решили полностью проблему переобучения.

Причиной стала коадаптация.

Совместная адаптация в нейронной сети

Рисунок 3. Совместная адаптация соединений узлов в нейронной сети. Одной из основных проблем при изучении больших сетей является совместная адаптация. В такой сети, если все веса изучены вместе, обычно некоторые из соединений будут иметь больше возможностей для прогнозирования, чем другие.

В таком сценарии при итеративном обучении сети эти мощные соединения изучаются больше, а более слабые игнорируются. За многие итерации обучается только часть соединений узлов. А остальные перестают участвовать.

Это явление называется коадаптацией. Этого нельзя было предотвратить с помощью традиционной регуляризации, такой как L1 и L2. Причина в том, что они также регуляризируются на основе предсказательной способности соединений. Благодаря этому они становятся близкими к детерминированным в выборе и отклонении весов. И, таким образом, снова сильный становится сильнее, а слабый становится слабее.

Основным следствием этого было: увеличение размера нейронной сети не помогло бы . Следовательно, размер нейронных сетей и, следовательно, точность стали ограниченными.

Затем последовал Dropout. Новый подход к регуляризации. Это разрешило коадаптацию. Теперь мы могли создавать более глубокие и широкие сети. И используйте силу предсказания всего этого.

На этом фоне давайте углубимся в математику отсева. Вы можете сразу перейти к разделу Dropout, эквивалентному регулярной сети , для выводов .

Рассмотрим одноуровневый линейный блок в сети, как показано на рис. 4 ниже. Подробную информацию см. в [2].

Рис. 4. Одноуровневая линейная единица вне сети.Это называется линейным из-за линейной активации, f(x) = x. Как видно на рисунке 4, выходные данные слоя представляют собой линейно взвешенную сумму входных данных. Мы рассматриваем этот упрощенный случай для математического объяснения. Результаты (эмпирически) справедливы для обычных нелинейных сетей.

Для оценки модели мы минимизируем функцию потерь. Для этого линейного слоя мы рассмотрим обычное уравнение наименьших квадратов,

уравнение. 1 показаны потери для обычной сети и уравнения. 2 для отсева сети. В уравнении 2 процент отсева равен 𝛿, где 𝛿 ~ Бернулли( стр. ). Это означает, что 𝛿 равно 1 с вероятностью p и 0 в противном случае.

Обратное распространение для обучения сети использует метод градиентного спуска. Поэтому мы сначала рассмотрим градиент сети отсева в уравнении. 2, а затем перейти к обычной сети в уравнении. 1.

Теперь попробуем найти связь между этим градиентом и градиентом обычной сети. С этой целью предположим, что мы получаем w ’ = p * w в уравнении. 1. Следовательно,

Взяв производную уравнения 4, находим,

Теперь самое интересное. Если мы найдем математическое ожидание градиента сети Dropout, мы получим

. Если мы посмотрим на уравнение. 6, математическое ожидание градиента с Dropout равно градиенту регуляризованной регулярной сети Eɴ, если w ’ = p * w.

Это означает, что минимизация потерь отсева (в уравнении 2) эквивалентна минимизации регулярной сети , показанной в уравнении. 7 ниже.

То есть, если вы продифференцируете регуляризованную сеть в уравнении. 7, вы получите (ожидание) градиент сети Dropout, как в уравнении. 6.

6.

Это глубокие отношения. Отсюда мы можем ответить:

Почему показатель отсева, p = 0,5, дает максимальную регуляризацию?Это потому, что параметр регуляризации, p (1- p ) в уравнении. 7, максимально при p = 0,5.

Какие значения p следует выбирать для разных слоев?В Keras аргумент процента отсева (1- p ). Для промежуточных слоев идеально подходит выбор (1- p ) = 0,5 для больших сетей. Для входного слоя (1- p ) следует оставить около 0,2 или ниже. Это связано с тем, что удаление входных данных может отрицательно сказаться на обучении. A (1- p ) > 0,5 не рекомендуется, так как он отбраковывает больше соединений без усиления регуляризации.

Почему мы масштабируем веса w на p во время теста или вывода? Поскольку ожидаемое значение сети отсева эквивалентно обычной сети с ее весами, масштабированными с коэффициентом отсева p . Масштабирование делает выводы из сети Dropout сопоставимыми с полной сетью. Существуют также вычислительные преимущества, которые объясняются с точки зрения ансамблевого моделирования в [1].

Масштабирование делает выводы из сети Dropout сопоставимыми с полной сетью. Существуют также вычислительные преимущества, которые объясняются с точки зрения ансамблевого моделирования в [1].

Прежде чем мы пойдем, я хочу коснуться Gaussian-Dropout.

Как мы видели ранее, в Dropout мы сбрасываем соединение с вероятностью (1- p ). Положите математически, в уравнении. 2 у нас есть веса соединений, умноженные на случайную величину, 𝛿, где 𝛿 ~ Бернулли ( p ).

Эту процедуру Dropout можно рассматривать как установку вентиля Бернулли на каждое соединение.

Рисунок 5. Выпадение в виде вентиля Бернулли на соединениях.Мы можем заменить ворота Бернулли другими воротами. Например, ворота Гаусса. И это дает нам Gaussian-Dropout.

Рис. 6. Выпадение, обобщенное на гауссовский вентиль (вместо бернуллиевского).Было обнаружено, что Gaussian-Dropout работает так же хорошо, как и обычный Dropout, а иногда и лучше.

При использовании Gaussian-Dropout ожидаемое значение активации остается неизменным (см. уравнение 8). Поэтому, в отличие от обычного Dropout, во время вывода не требуется масштабирование веса.

уравнение 8). Поэтому, в отличие от обычного Dropout, во время вывода не требуется масштабирование веса.

Это свойство также дает Gaussian-Dropout вычислительное преимущество. Мы рассмотрим производительность Gaussian-Dropout в следующем посте. А пока одно предостережение.

Хотя идея Dropout Gate может быть распространена на дистрибутивы, отличные от Бернулли, рекомендуется понимать, как новый дистрибутив повлияет на ожидание активаций. И исходя из этого следует делать соответствующее масштабирование активаций.

В этом посте мы рассмотрели математику, стоящую за Dropout. Мы работали над математикой в некоторых упрощенных условиях. Однако результаты распространяются на общие случаи глубокого обучения. В общем, мы поняли,

- Связь между отсевом и регуляризацией,

- Коэффициент отсева 0,5 приведет к максимальной регуляризации, а

- Обобщение отсева до GaussianDropout.

- Шривастава Н., Хинтон Г.

, Крижевский А., Суцкевер И. и Салахутдинов Р. (2014). Dropout: простой способ предотвратить переоснащение нейронных сетей. Журнал исследований машинного обучения , 15 (1), 1929–1958.

, Крижевский А., Суцкевер И. и Салахутдинов Р. (2014). Dropout: простой способ предотвратить переоснащение нейронных сетей. Журнал исследований машинного обучения , 15 (1), 1929–1958. - Балди, П., и Садовски, П.Дж. (2013). Понимание отсева. В Достижения в области нейронных систем обработки информации (стр. 2814–2822).

глубокое обучение — значение отсева

спросил

Изменено 3 года назад

Просмотрено 2к раз

$\begingroup$ Что означает model.add(Dropout(0.4)) значит в Керасе?

Означает ли это игнорирование 40% нейронов в нейронной сети? ИЛИ Означает ли это игнорирование нейронов, дающих вероятность = 0,4?

- глубокое обучение

- керас

- компьютерное зрение

Это означает, что вы случайным образом выбираете 40% нейронов и устанавливаете их веса равными нулю для прямого и обратного проходов, т.

Взгляните сюда, чтобы узнать о некоторых преимуществах и преимуществах.

Ознакомьтесь со всеми подробностями стандартного Dropout здесь. Важно отметить, что оставшиеся веса обычно масштабируются по значению p , чтобы ожидаемое среднее значение весов оставалось примерно постоянным на протяжении многих итераций. Различные фреймворки глубокого обучения масштабируют веса в разных точках, но причина одна и та же.

Из соответствующей документации Keras:

$\endgroup$ $\begingroup$Отсев заключается в случайном установлении доли входных единиц на 0 при каждом обновлении во время обучения, что помогает предотвратить переоснащение.

Выпадение , как следует из названия , случайный выбор и отклонение ( выпадение ) некоторых слоев нейронов, благодаря чему достигается эффект ансамбля (из-за случайного выбора — каждый раз деактивируются разные нейроны , каждый раз разные сети предсказания).

Помогает предотвратить переоснащение (как это делает ансамбль).

Конкретная вероятность 0,4 говорит о том, что 40% узлов слоя каждый раз игнорируются.

$\endgroup$ 1Зарегистрируйтесь или войдите в систему

Зарегистрируйтесь с помощью Google Зарегистрироваться через Facebook Зарегистрируйтесь, используя адрес электронной почты и парольОпубликовать как гость

Электронная почтаОбязательно, но не отображается

Опубликовать как гость

Электронная почтаТребуется, но не отображается

Нажимая «Опубликовать свой ответ», вы соглашаетесь с нашими условиями обслуживания и подтверждаете, что прочитали и поняли нашу политику конфиденциальности и кодекс поведения.

После пропускания сквозь сита измельченной известняковой породы выходит масса с модулем крупности гранул от 2 до 5. В отличие от других разновидностей, известняковые гранулы растворяются в воде, их добавляют в цемент при приготовлении строительных растворов.

После пропускания сквозь сита измельченной известняковой породы выходит масса с модулем крупности гранул от 2 до 5. В отличие от других разновидностей, известняковые гранулы растворяются в воде, их добавляют в цемент при приготовлении строительных растворов.

, Крижевский А., Суцкевер И. и Салахутдинов Р. (2014). Dropout: простой способ предотвратить переоснащение нейронных сетей. Журнал исследований машинного обучения , 15 (1), 1929–1958.

, Крижевский А., Суцкевер И. и Салахутдинов Р. (2014). Dropout: простой способ предотвратить переоснащение нейронных сетей. Журнал исследований машинного обучения , 15 (1), 1929–1958.